Читать книгу La pirámide visual: evolución de un instrumento conceptual - Carlos Alberto Cardona - Страница 9

На сайте Литреса книга снята с продажи.

Introducción

Оглавление¿Cómo es posible que, al abrir los ojos, se me imponga un escenario poblado de objetos, algunos fijos, otros en movimiento? ¿Cómo es posible que pueda valerme de esa puesta en escena para adquirir (o inferir) información acerca de otros objetos que tengo por externos y que habrían de detonar causalmente la presencia de los primeros? ¿Cómo es posible que pueda valerme de esa información para dirigir mi acción inmediata en un ambiente que puede resultarme agresivo unas veces y atractivo otras? Estas son preguntas que han inquietado profundamente a filósofos y hombres de ciencia, quienes durante siglos han tratado de explicar los orígenes y la constitución de nuestra experiencia.

Asimismo, contamos con instrumentos de recepción que continuamente son afectados por acontecimientos físicos que tienen lugar en nuestras vecindades. Pero no nos limitamos a padecer pacientemente dichas afecciones; podemos también, gracias a ellas, reaccionar para orientar nuestro curso de acción y así sacar provecho de las circunstancias. De igual modo, podemos informar a otros acerca de la manera como esas afecciones se nos presentan. En forma permanente reaccionamos ante un ambiente que de continuo nos asalta. ¿Cómo es posible toda esa empresa asombrosa? En términos muy generales, esa empresa congenia: afección, recepción, anticipación, coordinación de la acción inmediata y, en algunas ocasiones, evaluación.

No es tarea fácil responder aquellas preguntas. De hecho, tampoco resulta fácil dar con el lenguaje adecuado para formular las preguntas precisas. No sorprende, entonces, que los grandes sistemas de filosofía que antaño atraían a las mentes más preclaras, solieran empezar respondiendo la pregunta general: ¿cómo es posible la mera receptividad sensorial? Tampoco causa sorpresa que, cuando estos sistemas querían ofrecer una respuesta general, se sintieran atraídos por la visión como un caso paradigmático.

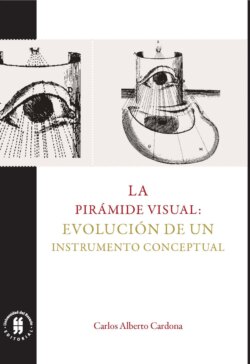

El presente trabajo ofrece una reconstrucción racional de un programa de investigación que ha procurado ocuparse de los enigmas propios de la visión, anteponiendo como instrumento conceptual una pirámide, que presupone que una de las caras del objeto a observar ocupa la base, mientras el receptor se instala en el vértice.

Consideremos la siguiente descripción, para la cual la redacción en primera persona es fundamental. Me siento sobre un prado, dispongo algunos de los objetos que traigo conmigo para que estén a la mano; entre ellos, algunos libros. Al fondo, advierto un conjunto de árboles que sirve de antesala a un bosque sembrado sobre la montaña que delimita el paisaje. Me dejo sorprender por la escena, dominada en el fondo por un tapete verde, interrumpido por sombras que le dan cierto realce. Si elevo mi cabeza, en el escenario se impone, por la parte superior, el azul que atribuyo al cielo; si bajo mi cabeza, todo el escenario es ocupado por el verde que atribuyo al prado. Cuando giro mi cabeza a la derecha, toda la escena se desplaza a la izquierda: las manchas del borde izquierdo desaparecen, en tanto que el borde derecho es ahora ocupado por nuevas imágenes. Es como si estuviese sentado en un teatro y, mientras mantengo firme mi cabeza, un grupo de operarios empujase los carteles que sirven de utilería y que simulan un paisaje. Pero no hay nadie que empuje la montaña del fondo (al menos eso creo).

La escena se interrumpe con la repentina interposición de un apéndice, una prótesis que parece responder a mis demandas; ella se mueve hacia uno de los libros que había dispuesto a la mano. Cuando mi mano no puede avanzar más por la resistencia que ofrece el libro, descubro la correlación entre las cinestesias musculares y ciertas manchas presentes en mi campo visual. Me siento inclinado a creer que hay objetos fuera de mí, objetos que se resisten cuando mi mano intenta moverlos y que se dejan anticipar por registros que dejan en mi campo visual. Cuando mi mano parece empujar y alejar al objeto que parece encontrarse al frente de mí, descubro que la mancha que lo anticipa ocupa ahora una región más pequeña en el campo visual. Si acerco el objeto demasiado, la mancha en el campo visual crece con tal celeridad, que oculta buena parte de la escena del fondo.

Esta descripción presenta una experiencia prodigiosa y, al mismo tiempo, misteriosa: los objetos allende mi presencia se dejan ver, ellos dejan huellas en mi campo visual, huellas con las que yo anticipo qué tanto debo extender mi brazo para asirlos. La situación misteriosa se puede plantear así: las manchas que anidan en mi campo visual me invitan a creer que hay objetos fuera de mí que ofrecen resistencia táctil, objetos que covarían de algún modo con dichas manchas.

El misterio se puede recrear y presentar de una manera profunda, y hermosa a la vez, si nos valemos de una obra pictórica de René Magritte (1898-1967) y del comentario que el pintor belga preparó para explicar el sentido de su obra (véase figura 1). Me refiero a La condición humana I.

Figura 1. La condición humana I, René Magritte, 1933, Washington: National Gallery of Art

Fuente: Hand (2004, # 355, p. 425).

El cuadro presenta parte del estudio de un pintor —la parte que contiene el lienzo sobre el que trabaja—, una ventana que deja ver el paisaje de fondo y la composición que sobre el lienzo representado ha logrado plasmar el incógnito pintor. El comentario explica el curioso título:

Frente a una ventana, vista desde el interior de una habitación, ubiqué una pintura que representaba exactamente la parte del paisaje que quedaba oculta por la propia pintura. En consecuencia, el árbol representado impide la visualización del árbol situado detrás, fuera de la habitación. Para el espectador, el árbol estaba simultáneamente en el salón, en la pintura, y por fuera del salón, en el paisaje real. Existe de dos formas simultáneas en la mente del espectador: dentro del cuarto, en la pintura, y fuera del cuarto, en el paisaje real. Esta existencia en dos espacios diferentes a la vez es semejante a la presencia del pasado y del presente, como en un déjà vu (Magritte, 2016, pp. 65-66).1

El cuadro ilustra la manera como nos hemos acostumbrado a presentar nuestras experiencias visuales. Cuando vemos el mundo, creemos estar experimentando una visión doble: lo consideramos exterior a nosotros, aun cuando lo vivimos como si fuera una representación mental de nuestras experiencias internas. Así se resume la condición humana de Magritte: somos animales con visión doble. Magritte consigue que el espectador vea dos árboles, porque así estamos acostumbrados a reaccionar ante las escenas pictóricas que aparecen en nuestros campos visuales. Esto es, tenemos, en nuestro campo visual, representaciones internas (copias bien logradas de otros objetos) y nos animamos a creer que allende nuestra vida interior existen otros objetos que sirven de modelo para las copias internas.

Si las manchas que aparecen en mi campo visual sugieren que hay un gato sobre la alfombra, me sentiré inclinado a creer que detrás del lienzo en el que se exhibe mi campo visual (es decir, al frente mío) hay un gato sobre una alfombra. ¿Es esta condición humana algo intrínseco (innato) o un recurso que aprendimos a usar con la experiencia?

La reconstrucción racional que ofrecemos en este texto puede dar las pistas para una naturalización genética y cultural de la visión doble. La ventana figura el aparato receptor con toda su complejidad; las cortinas figuran los párpados que cierran o permiten las afectaciones de periferia; el lienzo del pintor hace las veces del campo visual y su horizonte; el árbol y el paisaje representado simulan el contenido no interpretado, presente en nuestro campo visual.

El árbol imaginado detrás —el árbol que no se ve— hace las veces del objeto que, aunque inaprehensible directamente, es el detonante causal de su propia representación. Si las cortinas se cierran, podemos imaginar que el lienzo, por un tiempo breve, sigue siendo visible gracias a una tenue luz interior que remeda la iluminación ambiente.

Los trazos de continuidad entre el paisaje material y su copia no solo muestran los puntos de ruptura; ilustran, también, que la escena pictórica debe contener claves que sugieran la creencia en la duplicación visual. El espectador del cuadro hace las veces del sensorio2 que, a la distancia, evalúa e interpreta, sin hacer parte de la escena pictórica, lo que se le da en el campo visual.

Para hacerse cargo de las preguntas formuladas inicialmente, se necesita convocar programas de investigación provenientes de muy diversos saberes o disciplinas. Las preguntas demandan la intervención de la física, toda vez que se advierte el papel protagónico de la luz (su naturaleza, su comportamiento y su forma de interactuar con los cuerpos) y de la activación eléctrica de la retina, de los nervios y del cerebro. Demanda, también, la presencia de la biología, toda vez que los aparatos receptores hacen parte de organismos vivos empeñados en anticipar condiciones favorables o desfavorables en el medio ambiente circundante; el que las condiciones sean unas u otras, determina el curso de acción que habría de esperarse de un individuo funcional. Requiere, además, de la participación de la fisiología y la anatomía, toda vez que los órganos receptores (incluyendo el cerebro) suponen una articulación muy compleja de diversas partes con esquemas de funcionamiento muy preciso y especializado. La participación de la psicología igualmente es central, si se tiene en cuenta que buena parte de las claves de la compleja percepción sensorial demanda patrones muy sofisticados de aprendizaje, mezclados con fenómenos emocionales que contribuyen, entre otras cosas, a formar un punto de vista. La geometría, asimismo, es imprescindible, si se admite que muchos modelos que pretenden anticipar los trayectos de la luz deben apoyarse en consideraciones geométricas. Finalmente, requiere la filosofía, toda vez que los programas de investigación convocados demandan compromisos ontológicos y metodológicos que resultan centrales para la toma de decisiones y la valoración de ciertas conjeturas. La filosofía también es pertinente dado que buena parte de los debates tienen que ver con la naturaleza de la conciencia y el aspecto fenomenológico de nuestra experiencia.

Presentamos a continuación una descripción sucinta del tipo de reconstrucción racional que nos proponemos ofrecer; caracterizamos, de manera muy general, el programa de investigación que nos ocupa y, por último, definimos las fases que hemos perfilado para la reconstrucción racional y que delimitan los capítulos del libro.

Reconstrucciones racionales de programas de investigación

Las demandas de investigación científica, en el marco de las ciencias naturales, exigen gran habilidad para construir sofisticados edificios teóricos y el despliegue de una buena cantidad de intervenciones que permitan evaluar las expectativas teóricas contra el comportamiento de los entornos naturales que constituyen el objeto de investigación. La evaluación que pudiese resultar exitosa, con los criterios de éxito que se hayan definido en el marco de un espíritu de la época, ofrece buenas razones para creer en los constructos teóricos o para desconfiar de ellos.

A comienzos del siglo XX, en el entorno de la investigación filosófica, se inició una profunda discusión, con el ánimo de abrir nuevos espacios de fundamentación epistemológica, que habrían de armonizar con los revolucionarios desarrollos de la nueva ciencia (relatividad, mecánica cuántica, teoría de la evolución, nuevas geometrías y lógicas, teoría de la probabilidad, psicología experimental y fisiología). Buena parte de estas discusiones dio origen a la filosofía analítica en el mundo anglosajón y al Círculo de Viena en el ambiente continental.

Uno de los puntos centrales de la discusión tuvo que ver con la elección y la caracterización de la mínima unidad susceptible de evaluación empírica. Esta unidad debía ser neutral, en relación con cualquier compromiso teórico; objetiva, para garantizar que cualquier observador, en cualesquiera circunstancias, pudiese llegar al mismo veredicto, y pública, en el sentido de que cualquier investigador pudiese replicar las condiciones y circunstancias de la evaluación.

En el ambiente, a pesar de las grandes diferencias, existía cierto optimismo con la expectativa de lograr un acuerdo al respecto. Si pudiésemos definir con claridad dicha unidad o base empírica, podríamos separar, por un lado, las teorías ancladas en una sólida evaluación empírica y, por otro, las especulaciones libres.

El primer candidato serio que se propuso como unidad mínima de evaluación fue la proposición simple. Además de los términos lógicos, este tipo de proposición solo debería contener términos que pudieran referir a datos sensoriales (sense data), que carecen de compromisos teóricos y se tienen por simples e inmediatos. Las proposiciones que solo tienen nombres que refieren a dichos datos fueron mencionadas con diferentes apelativos: “oraciones protocolares”, “oraciones observacionales”, “proposiciones atómicas”, etc.

La idea de concebir un escenario de evaluación científica neutral, apoyado simplemente en términos observacionales y oraciones protocolares, dejó ver su naturaleza efímera y fue contundentemente derrotada. Argumentos poderosos, como los de Norwood Russell Hanson (1924-1967), mostraron que no es conveniente insistir en concebir un tipo de observación absolutamente neutral; antes al contrario, toda observación está contaminada con compromisos teóricos (Hanson, 1958). Así las cosas, cuando decimos que una proposición elemental es verdadera, este enunciado está sujeto a la interpretación que demos a los términos observacionales que, a su vez, son teórico-dependientes. Los resultados citados dejaron poco espacio para seguir confiando en las proposiciones atómicas como unidades mínimas de evaluación empírica.

Supongamos, en gracia de discusión, que contamos con criterios neutrales para decidir si una proposición atómica es verdadera. Los enunciados de la ciencia que resultan de importancia capital no son propiamente las proposiciones atómicas, sino los enunciados con cuantificadores universales de alcance no restringido; enunciados de la forma “todos los cuervos son negros”. Para evaluar empíricamente este tipo de proposiciones, necesitamos criterios lógicos que autoricen la transición desde enunciados singulares reconocidos como verdaderos, a enunciados también verdaderos, con cuantificadores sin restricción en el alcance. De contar con estos criterios, habríamos resuelto el problema de la inducción.3

Los poderosos argumentos de Nelson Goodman (1906-1998), entre otros argumentos, llevaron a concluir que siempre es posible construir enunciados universales, que coincidan en sus instancias para una base finita de observación, aunque puedan diferir substancialmente para instancias aún no observadas (Goodman, 1983, pp. 59-83). En ese orden de ideas, ninguna base finita de observaciones puede esgrimirse como respaldo definitivo para un enunciado con cuantificadores universales proyectables, sin restricción alguna. Así las cosas, la mínima unidad de evaluación empírica no es ni la proposición elemental, ni el enunciado universal.

Las críticas al reduccionismo formuladas por Willar Van Orman Quine (1908-2000) condujeron a considerar la posibilidad de defender alguna forma de holismo (Quine, 1951). Es decir, no tienen que ser las proposiciones elementales aisladas las que se someten al tribunal de la contrastación; se puede pensar, más bien, en hacer, de las teorías, la mínima unidad de evaluación empírica.

Es cierto que son muy discutidas la naturaleza y la estructura de una teoría. Podemos, sin embargo, estar de acuerdo en que una teoría es un cuerpo de principios básicos, a partir de los cuales, con ciertas condiciones antecedentes que definen el marco de aplicación, es posible inferir algunas proposiciones que se pueden someter a contrastación.

Los principios constituyen el corazón de las teorías y, dado su carácter universal y el hecho de que en su contenido no puede haber términos que refieran a objetos singulares, antes que proposiciones, son esquemas para producir proposiciones. Una teoría es, pues, un esquema para ocuparse de lo que todavía no es el caso (predicciones), de lo que fue el caso y ya no lo es (postdicciones) o de lo que podría haber sido el caso sin serlo en el momento (evaluaciones contrafácticas o subjuntivas).

Dado que en los principios básicos de una teoría no se puede hacer mención a objetos singulares, no podemos valernos de tales principios para hacer predicciones, postdicciones o evaluaciones contrafácticas, si no contamos con condiciones auxiliares que indiquen cómo podemos reemplazar, en las leyes universales, los términos vacíos de referencia, es decir, los términos teóricos, por los términos que sí refieren en dichas condiciones auxiliares.4

La evaluación empírica de teorías enfrenta dos, entre otros tantos, problemas básicos: puede ocurrir que, siendo verdaderas todas las consecuencias finitas de una teoría, muchos esquemas teóricos, aunados con condiciones antecedentes adecuadas, conduzcan a las mismas consecuencias, pero difieran en consecuencias aún no observadas. También puede acontecer que una consecuencia verdadera se logre a partir de una teoría falsa, armonizada con condiciones auxiliares también falsas.5 En ese orden de ideas, las teorías no pueden ser la mínima unidad de evaluación empírica.

Karl Popper (1902-1994) sugirió una forma ingeniosa para conservar esquemas deductivos en la práctica científica y salvar las dificultades que surgen al reconocer la imposibilidad de dar una respuesta positiva al problema de la inducción. Si bien es cierto que la verdad de p (las consecuencias que se derivan de la aplicación de una teoría) no garantiza, de suyo, la verdad de las teorías que permiten su anticipación, sí podemos aseverar que la falsedad de p autoriza inmediatamente el reconocimiento de la falsedad de las teorías así evaluadas. En ese orden de ideas, es el modus tollens el que rige el esquema fundamental de la práctica científica y no el modus ponens. Contamos con criterios para desacreditar teorías, mientras carecemos de criterios para verificarlas. La tarea básica de la actividad científica no consiste en verificar teorías que tenemos por verdaderas, sino en falsear teorías o procurar hacerlo (Popper, 1935/1991, pp. 27-47).

La propuesta de Popper encara dos dificultades centrales: por un lado, presupone que hemos resuelto el problema de la base empírica, esto es, que existen criterios para decidir si una proposición elemental es falsa con independencia de cualquier compromiso teórico; por otro, si aceptamos que podemos reconocer la falsedad de p sin adquirir compromisos teóricos, no es del todo seguro que podamos concluir con ello la falsedad de la teoría que facilitó su predicción. Puede ocurrir que la dificultad se encuentre en las condiciones auxiliares, por ejemplo. Más aún, si aceptamos que las condiciones auxiliares no ofrecen dificultad, todavía podemos intentar realizar modificaciones ad hoc en la teoría para salvar las apariencias. Popper aceptó la legitimidad de salvar teorías agregando modificaciones ad hoc, siempre que este movimiento incrementara el grado de falsabilidad de la teoría en su conjunto.

Imre Lakatos (1922-1974) mostró que hay una buena cantidad de episodios históricos que sugieren que los hombres de ciencia no son del todo proclives a aceptar las recomendaciones metodológicas de Popper (Lakatos, 1978, p. 30). Por ejemplo, en ocasiones, los científicos proceden con lentitud irracional: aun cuando reconocen que la teoría tiene una instancia de falsación y aceptan que las condiciones auxiliares son confiables, aun así se demoran en desacreditar la teoría (v. gr. la demora en incorporar las anomalías del corrimiento del perihelio de Mercurio entre los falsadores potenciales de la gravitación newtoniana). También puede darse que los hombres de ciencia se empeñen en defender teorías, a pesar de la abundante evidencia en contra (v. gr. Galileo aceptó la mecánica celeste heliocéntrica, pese a la abrumadora evidencia en contra de la rotación de la Tierra).

El panorama descrito hasta el momento sugiere una crisis profunda en el marco de quienes han querido ofrecer un fundamento racional para la práctica científica, al mismo tiempo que han pretendido desacreditar las especulaciones que denominan “metafísicas”. Este horizonte nos deja con tres alternativas abiertas: por un lado, se puede defender una forma de anarquismo (Paul Feyerabend [1924-1994]), proclive a sostener que no tiene sentido buscar criterios de demarcación y que, al contrario, lo que puede animar el progreso científico es dejar abierta la posibilidad de escuchar todas las alternativas en igualdad de condiciones; no contamos con criterios para declarar ciertas prácticas como racionales, mientras desacreditamos otras con el apelativo de “irracionales” (Feyerabend, 1975/1986).

Por otro lado, se puede defender una forma de elitismo (Thomas Kuhn [1922-1996]), que sostiene que hemos de calificar como científicas solo ciertas prácticas que se han acreditado socialmente y se han erigido como paradigmas (Kuhn, 1962/2004). En ese orden de ideas, la dinámica que explica qué prácticas se han acreditado, además de incorporar la consideración de ciertos valores epistémicos, puede verse afectada por la pugna de intereses o de relaciones de poder. Cuando ello se puede constatar, el curso que han de seguir las acreditadas investigaciones científicas se puede explorar con las herramientas diseñadas por la sociología o la antropología de la ciencia.

Por último, se puede insistir en la búsqueda de criterios o metodologías que rescaten algún tipo de racionalidad propia para la práctica científica y que sirvan para distinguirla de otro tipo de prácticas. En esta tercera alternativa es posible pensar en: 1) enfoques inductivistas (programas que intenten lidiar con las limitaciones que impone el hecho de no poder resolver positivamente el problema de la inducción); 2) enfoques falsacionistas (programas que sugieran criterios adecuados para descartar teorías); y 3) enfoques que concilien algunas variantes de las propuestas enumeradas. El aporte de Lakatos pretende ubicarse precisamente en este último tipo de conciliación.

Las dificultades hasta aquí señaladas condujeron a Lakatos a proponer que la mínima unidad de evaluación empírica debía ser un programa de investigación. La propuesta supone aceptar un holismo más fuerte que el de Duhem-Quine; un holismo que abarca no una teoría aislada, sino un conjunto de teorías cuya actividad se despliega en extensos períodos. También supone aceptar las tesis del falsacionismo, pero en una dimensión histórica, lo que conduce a explorar series de teorías o conjuntos de series de teorías. Es decir, el abandono de una teoría reputada no se produce simplemente porque una instancia de falsación nos obliga a ello, sino porque: 1) aun cuando los investigadores han tenido la oportunidad de realizar todos los intentos razonables por defender la teoría, ellos han fracasado en estos; y 2) otra teoría novedosa se insinúa en el horizonte y ha mostrado su capacidad para dar cuenta de las dificultades de la primera, sin dejar de ofrecer explicaciones prometedoras de los hechos descritos exitosamente por la teoría derrotada. Así las cosas, una dificultad empírica no impone la determinación de abandonar, sino la recomendación de esperar mientras se da la oportunidad para hacer ajustes o para permitir la emergencia de nuevas orientaciones teóricas.

El abandono de una teoría no se produce, pues, por un dictamen instantáneo, sino por un proceso que comporta dimensiones temporales considerables. Así resume Lakatos su propuesta:

[…] cualquier teoría tiene que ser evaluada junto con sus hipótesis auxiliares, condiciones iniciales, etc., y especialmente, junto con sus predecesoras, así que podamos apreciar los cambios que le dieron origen. Así las cosas, lo que nosotros apreciamos es una serie de teorías, más que las teorías aisladas (1978, p. 33).

Un programa de investigación, en la perspectiva de Lakatos, se define como una serie de teorías [T1, T2, T3,… Tn], en las que se puede identificar una base de continuidad, protegida por una heurística negativa. Este elemento de continuidad se define como el núcleo firme del programa y resume todos los preceptos, los métodos y las prácticas que los investigadores del programa, consciente o inconscientemente, se comprometen a proteger de todas las instancias falseadoras que puedan encontrarse en el camino.

Como unidad mínima de evaluación, un programa de investigación comporta una extensa duración en el tiempo. Los programas de investigación más exitosos pueden llegar a contabilizarse en siglos de duración.

Lakatos llama “heurística negativa” a la decisión metodológica, entre quienes adscriben el programa de investigación, de no modificar el núcleo firme. Todas estas movidas se recogen bajo el término de cinturón protector.

Las siguientes palabras de Lakatos sintetizan la propuesta:

Uno de los rasgos cruciales del falsacionismo sofisticado es que reemplaza el concepto de teoría como el concepto básico de la lógica del descubrimiento, por el concepto de serie de teorías. Lo que es evaluado como científico o pseudocientífico, es una serie de teorías y no una teoría dada. Así que los miembros de tales series de teorías están conectados por una sorprendente continuidad, que los agrupa en programas de investigación. Esta continuidad —reminiscente de la “ciencia normal” de Kuhn— cumple un rol central en la historia de la ciencia; los problemas principales de la lógica del descubrimiento solo pueden ser satisfactoriamente discutidos en el marco de una metodología de programas de investigación (1978, pp. 46-47).

Cuando evaluamos un programa de investigación, no concluimos de él que es verdadero o falso. De hecho, la evaluación debe incorporar algún tipo de determinación temporal, toda vez que la comparación demanda aspectos históricos. En la práctica científica, guardamos la esperanza de que, en la dinámica de una pugna entre programas de investigación rivales, los nuevos programas tengan un mayor contenido empírico que sus predecesores. Lakatos prefiere dictámenes como “programa de investigación progresivo”, “programa de investigación estancado”, “programa de investigación superado por otro rival”.

El programa de investigación se dice progresivo cuando: 1) los movimientos adelantados en el cinturón protector permiten prever hechos nuevos que no podrían advertirse con programas alternativos, y 2) estas anticipaciones hallan contrastaciones prima facie satisfactorias. El programa se dice regresivo o estancado si no logra producir hechos nuevos.

Un programa de investigación es progresivo si su crecimiento teórico anticipa su crecimiento empírico, predice hechos nuevos antes de que ellos salgan a la luz (la predicción antecede la demanda de explicación). Un programa es regresivo (o se encuentra estancado) si su crecimiento teórico marcha a la saga del crecimiento empírico (si la demanda de explicación es dominante) (Lakatos, 1978, p. 112).

Por su parte, el programa se dice superado por otro rival, si este segundo anticipa hechos nuevos que encuentran contrastaciones prima facie satisfactorias y logra incorporar, en su seno, todas las victorias del programa superado.

Cito en extenso la valoración que Lakatos hizo de ciertas fases del programa de investigación de la mecánica newtoniana, para exponerla como ejemplo del tipo de evaluación que se espera en el marco de la metodología que propone. El texto de Lakatos nos sirve como referencia para marcar las expectativas del tipo de reconstrucción racional que ofrecemos en este libro:

Si nosotros analizamos este caso [el caso de cierta fase de la mecánica de Newton exhibida como ejemplo], resulta que cada paso sucesivo en este ejercicio predice algún hecho nuevo; cada paso representa un incremento en el contenido empírico: el ejemplo constituye un cambio teórico consistentemente progresivo.[6] Además, cada predicción quedó finalmente verificada […]. Mientras el “progreso teórico” (en el sentido aquí descrito) puede ser verificado inmediatamente, el “progreso empírico” no puede serlo, así que en un programa de investigación podemos vernos frustrados por una larga serie de “refutaciones” antes de que alguna ingeniosa y afortunada hipótesis auxiliar de contenido empírico superior convierta una cadena de defectos en una asombrosa historia de éxitos, o bien al revisar algunos “hechos” falsos o al agregar nuevas hipótesis auxiliares. Podemos entonces exigir que cada fase de un programa de investigación incremente el contenido de manera consistente; que cada fase constituya un cambio teórico consistentemente progresivo. Lo que necesitamos adicional a esto es que retrospectivamente se aprecie que el incremento de contenido fue corroborado: el programa como un todo también debe exhibir un cambio empírico intermitentemente progresivo. Nosotros no demandamos que cada fase produzca inmediatamente un nuevo hecho observado. Nuestro término “intermitentemente” da suficiente espacio racional para la adhesión dogmática a un programa en una etapa de “refutaciones” prima facie (1978, pp. 48-49).

Los enfoques mencionados difieren no solo en sus orientaciones filosóficas más básicas, sino también en la forma en la que encaran la historia de la ciencia. Así, los anarquistas se valen de la historia de la ciencia como laboratorio para mostrar que los hombres de ciencia de carne y hueso han sabido sortear con éxito sus dificultades al ignorar, deliberadamente, las prescripciones o recomendaciones de quienes pretenden que el espíritu científico sea la encarnación de una suerte de racionalidad pura. Ellos encuentran, en la historia de la ciencia, el laboratorio básico para refutar a quienes creen que el progreso de la ciencia exhibe el despliegue del espíritu absoluto. En ese orden de ideas, la historia de la ciencia falsea continuamente las expectativas de racionalidad impuestas por los enfoques que podríamos llamar “dogmáticos”.

A su vez, los elitistas construyen la historia de la ciencia de los vencedores. La historia de la ciencia ofrece un laboratorio que permite sacar a la luz las relaciones de poder que en determinados períodos posibilitan explicar por qué cierta perspectiva llegó a erigirse como paradigmática.

Los enfoques inductivistas suelen practicar cierto desprecio por la historia de la ciencia. Para ellos, la lógica de la justificación debe ser la preocupación central de la filosofía y esta puede ignorar por completo los aspectos contingentes que suelen atribuir a la lógica del descubrimiento.7 Esta última tiene que ser la preocupación de psicólogos, sociólogos o antropólogos. Aun así, si el inductivista se acerca a la historia de la ciencia, lo hará para contemplar cómo se avanza en la búsqueda de la verdad (las verificaciones positivas serán su mayor atractivo); si es el falsacionista quien quiere acercarse a la historia de la ciencia, lo hará para mostrar cómo es que hemos abandonado teorías refutadas (las refutaciones logradas en experimentos cruciales serán su mayor atractivo).

Lakatos, a diferencia de inductivistas y falsacionistas-popperianos, sostiene que la historia de la ciencia es un laboratorio crucial para poner en evidencia (o sacar a la luz) preceptos de la metodología de la investigación científica, preceptos que podríamos tener por razonables. Si bien la actividad científica no encarna la racionalidad pura que orienta las reflexiones de inductivistas o popperianos, no tenemos por qué esperar que las elecciones de teorías estén determinadas por relaciones de poder o por una suerte de foro democrático en el que todos tengan el mismo derecho para sostener, sin normas de control, lo que quieran. Podemos acercarnos a la historia para mostrar que los hombres de ciencia de carne y hueso que han trabajado en el marco de programas de investigación, han favorecido ciertas aproximaciones por encima de otras, en virtud de criterios que podemos tener por razonables, y que nada o muy poco tienen que ver con favorecimientos elitistas o con instancias de imperativos absolutos o racionales. Nótese que usamos aquí el adjetivo “razonable”, que suena menos fuerte que el adjetivo “racional”.

Queremos subrayar que la evaluación que hacemos está atada a las circunstancias y al devenir en el futuro del programa de investigación. Mostramos, en la reconstrucción racional que llevamos a cabo, que las decisiones tomadas por los investigadores fueron las más razonables, si se evalúan o se tiene en cuenta los alcances futuros de tales decisiones. Defendemos que, de no tomar esas decisiones, habría sido, quizá, más difícil llegar al resultado que después llegamos a apreciar. Así, entonces, en el marco de la razonabilidad que defendemos para el programa que nos ocupa, tales decisiones son importantes, porque facilitaron el tránsito hacia formas más complejas del programa de investigación.

En una hermosa paráfrasis del famoso dictum de Immanuel Kant (1724-1804), Lakatos presenta su orientación básica con respecto a la historia de la ciencia. Dice el autor: “‘La filosofía de la ciencia, sin historia de la ciencia, es vacía; la historia de la ciencia, sin filosofía de la ciencia, es ciega’” (Lakatos, 1978, p. 102).

Cuando el historiador de la ciencia encara sus entornos de investigación y lo hace orientado por alguna normatividad para la práctica científica, adelanta lo que Lakatos llama una “reconstrucción racional”. Cuando lleva a cabo su tarea, lo hace también como un científico natural: tiene un conjunto de expectativas teóricas, en este caso relativas a la normatividad científica, y busca herramientas que le permitan contrastar o refutar dichas expectativas.

La metodología de los programas de investigación de Lakatos ofrece un candidato a normatividad científica. Así pues, el historiador lakatosiano se acerca a los escenarios de investigación científica con el ánimo de imponer la normatividad de los programas de investigación. Quiere, en el ejercicio, sacar a la luz las anomalías propias de la evaluación empírica en el marco del programa que le interese y evalúa cuáles conviene aplazar en gracia de la heurística negativa. Rastrea la actitud adoptada por los practicantes, para juzgarla como razonable, dogmática o apresurada. Identifica fases de desarrollo progresivo, estancamiento o superación por otro programa rival. En la medida en que el historiador lakatosiano adelante juiciosas reconstrucciones racionales, somete a prueba su propia normatividad científica.

Si nos valemos del recurso de ofrecer paráfrasis de la obra de Kant, podemos arriesgar la siguiente: la filosofía acude a la ciencia llevando, en una mano, una normatividad, según la cual las decisiones tomadas parecen razonables, y en la otra, la historia de la ciencia. Así consigue ser instruida por la historia, mas no en calidad de discípula que escucha todo lo que el maestro quiere (como parece pretender Feyerabend), sino en la de juez autorizado, que obliga a los testigos a intervenir.8

Así, el historiador puede ofrecer evaluaciones exitosas o identificar anomalías en su propia normatividad. El falsacionista popperiano puede encontrar, en estas anomalías, la excusa adecuada para abandonar la normatividad conjeturada. El falsacionismo lakatosiano deja abierta una puerta de esperanza frente a las dificultades; el historiador orientado por la normatividad de los programas de investigación procurará conservar incólume el núcleo firme de su normatividad científica (heurística negativa) y complementar sus aportes con movimientos del cinturón protector.

Supondremos, pues, como hipótesis de trabajo, que la metodología de los programas de investigación ofrece una normatividad científica razonable para ofrecer una historia interna de empresas científicas de reconocida importancia y trayectoria. Una historia interna no agota la evaluación de una empresa científica.

Se puede mostrar, también, que una reconstrucción racional de algunos episodios de la historia de la ciencia identifica las dificultades que solo podrían encararse si la historia interna se complementa con una historia externa.9 “La historia de la ciencia”, explica Lakatos,

[…] es siempre más rica que sus reconstrucciones racionales. Aun así, una reconstrucción racional o historia interna es primaria; la historia externa es únicamente secundaria, dado que los problemas más importantes de la historia externa son definidos por la historia interna (1978, p. 118).10

El historiador interno selecciona una serie de eventos que procede a interpretar normativamente de acuerdo con el canon que haya seleccionado. Si se trata de la normatividad lakatosiana, una vez elegido el programa de investigación de interés, que de hecho debe cubrir períodos de muy larga duración, ofrecer una reconstrucción racional implica: 1) ofrecer, a manera de conjetura, una caracterización preliminar del núcleo firme; 2) identificar las teorías de la serie que supone el programa; 3) poner en evidencia —hasta donde sea posible— la evolución progresiva, entendida como el producto de los movimientos en el cinturón protector, y dar cuenta de la manera como dichos movimientos mantienen incólume el núcleo firme o aceptan muy ligeras modificaciones; 4) identificar anomalías razonablemente aplazadas; 5) constatar evaluaciones empíricas tanto favorables como problemáticas; 6) identificar períodos de estancamiento; 7) formular preguntas específicas que pudiesen ser asumidas por historiadores externos, y 8) establecer los vasos comunicantes o vínculos de cooperación con otros programas de investigación en áreas vecinas.

Caracterización general del programa de investigación

Lakatos participó en muchas empresas orientadas a ofrecer reconstrucciones racionales de muy diversos programas de investigación. A su llegada a Londres, después de huir de Hungría tras la invasión soviética en 1956, se unió al círculo de investigadores cercanos a Popper en la London School of Economics. Su tesis doctoral en Cambridge (1961) se transformó, después, en su famoso libro Proofs and Refutations (1976). Este libro, con un interesante título que parece adaptado de Conjectures and Refutations, de 1963, de Popper, ofrece, a partir de una normatividad muy cercana al falsacionismo, lo que podría ser una reconstrucción racional de algunos episodios de descubrimiento matemático. El libro está escrito en forma de diálogo y al final de la introducción explica el autor que la forma dialogada pretende ambientar lo que bien podría ser una “historia racionalmente construida o ‘destilada’” (Lakatos, 1976, p. 5).

Buena parte de las discusiones de Lakatos con Kuhn y Feyerabend tuvieron como escenario las diferencias entre los autores a la hora de evaluar los episodios históricos asociados con la revolución copernicana.11 La evolución del programa anclado en la mecánica de Newton y su superación por el programa de la relatividad especial y general ofrecieron al filósofo un escenario de la mayor importancia para defender su propia normatividad.

No pretendo ser exhaustivo en los ejemplos. Quiero, sin embargo, subrayar que, en todas las reconstrucciones adelantadas, el núcleo firme estaba constituido por un conjunto de principios o preceptos teóricos. Así, por ejemplo, en el núcleo firme del programa de la cosmología ptolemaica, se encuentran el principio que fija la inmovilidad de la Tierra en el centro del universo y el axioma platónico que exige que todo movimiento en el cielo ha de explicarse con círculos o combinaciones de ellos. El programa copernicano, que superó al ptolemaico, fija la inmovilidad del Sol y renuncia al axioma platónico.12 Por su parte, el programa newtoniano inmoviliza, en el núcleo firme, las tres leyes de la mecánica y la ley de la gravitación universal. A su vez, el programa relativista inmoviliza el principio de relatividad generalizado (principio de equivalencia) y la invarianza de la velocidad de la luz.

El programa de investigación cuya reconstrucción racional nos disponemos a ofrecer no fija en el núcleo, y en eso consiste buena parte de nuestra novedad, un conjunto de preceptos o principios teóricos. En el núcleo firme identificamos la defensa de un instrumento o artefacto conceptual. Adoptamos un modelo de reconstrucción, en el que la heurística negativa del programa que nos interesa inmoviliza un instrumento, más que un conjunto de preceptos teóricos. Defendemos que al inmovilizar un instrumento que resulta neutral frente a compromisos ontológicos, es posible encontrar, en el mismo programa de investigación, diferentes enfoques teóricos que, aunque contradictorios entre sí, gravitan en torno al uso del instrumento. Constatamos, entonces, que si bien los investigadores examinados adoptaban compromisos ontológicos en el uso que le daban al instrumento, estos compromisos eran prescindibles, de suerte que podemos atribuir el progreso del programa (en las fases de progreso) al uso mismo del instrumento, antes que a los compromisos ontológicos. En otras palabras, habría sido completamente razonable que ellos hubiesen presentado el núcleo firme tan solo en su naturaleza instrumental.

De ser correcta nuestra evaluación, tendría que ser una historia externa la que explicara por qué cada investigador, en su época y sus circunstancias, adoptó los compromisos ontológicos que acogió. Notamos que, aunque los compromisos de época a época diferían al extremo de parecer contradictorios, aun así los investigadores se identificaban en la defensa del instrumento. Nosotros nos limitamos a mostrar por qué era razonable defender la inmovilidad del instrumento en las épocas que identificamos como “progresivas”.

Presentamos, inicialmente, una definición provisional de “instrumento conceptual”. No pretendemos ser exhaustivos, ni aportar condiciones suficientes y necesarias para el uso de un concepto que, sabemos, requiere una pesquisa filosófica más cuidadosa. Queremos solo darnos una herramienta provisional para iniciar sin demoras la reconstrucción racional que nos interesa.

El Diccionario de la lengua española, de la Real Academia Española, brinda varias acepciones para “instrumento”, entre las cuales rescatamos las siguientes:

(1) Conjunto de diversas piezas combinadas adecuadamente para que sirva con determinado objeto en el ejercicio de las artes y oficios […]. (3) Aquello de que nos servimos para hacer una cosa. […] (5) Lo que sirve de medio para hacer una cosa o conseguir un fin (Real Academia Española, 1992, p. 1176).

Imaginemos que los ejercicios de ofrecer una explicación o de predecir con éxito un acontecimiento futuro hacen parte de prácticas que podemos considerar artes u oficios. No veo qué podría esgrimirse en contra. Así, entonces, cualquier conjunto de piezas combinadas de una manera simple para ofrecer explicaciones o predecir acontecimientos, puede tenerse por un instrumento. El telescopio más simple combina adecuadamente algunas lentes y consigue con ello que tengamos reportes de observación más cuidadosos que los que se obtienen con la vista desnuda, y que pueden ponerse al servicio de predicciones más finas. Este es, pues, un instrumento al servicio de la práctica científica; al igual que lo son el barómetro, el cronómetro, la cámara de niebla, etc.

El cálculo diferencial es, a su turno, un instrumento (conjunto de piezas combinadas adecuadamente), que permite manipular los ritmos de variación de una magnitud con respecto a otra. La invención de dicho instrumento le permitió a Newton controlar, cuidadosamente, la variación en las ratas de cambio de la velocidad de un móvil, cuando este se imaginaba sometido a la acción de fuerzas que variaban de acuerdo con conjeturas que se querían evaluar. A diferencia del telescopio o del barómetro, el cálculo engrana piezas de naturaleza conceptual.

Un mapa es también un instrumento conceptual: presenta, en un plano bidimensional, las relaciones estructurales que existen entre objetos regados en espacios tridimensionales. Ciertos objetos que tenemos por fijos se distribuyen en la superficie esférica de la Tierra, guardando ciertas relaciones de posición entre ellos. Un mapa presenta, en un plano bidimensional (vehículo de la representación), las relaciones que guardan estos objetos y procura, con base en una ley precisa de proyección, que esos arreglos bidimensionales sean isomórficos con los arreglos sobre la superficie de la Tierra.

En resumen, si un artefacto material o una invención de articulaciones conceptuales facilita, y en muchos casos hace posible, una anticipación empírica o contribuye a ofrecer una explicación, no veo tropiezo alguno en tener tales constructos como “instrumentos”. Si la articulación mencionada alude simplemente a piezas conceptuales, diremos, entonces, que se trata de un instrumento conceptual.

Un instrumento es un medio para alcanzar un fin. Podemos, entonces, dejar abierta la posibilidad de la existencia de muchos medios para realizar una misma faena. Sin embargo, podemos esperar que un instrumento facilite la realización de la tarea, es decir, esperamos que sea un medio que supere a los demás en algún aspecto claramente definido. Podemos rasgar una hoja de papel con nuestras manos; pero si la tarea es hacerlo respetando con cuidado unos márgenes finamente trazados, el uso de unas tijeras puede ayudarnos a lograr unos estándares de control más sofisticados.

En ese orden de ideas, podemos demandar de un instrumento que articule piezas simples en una combinación que logre, de acuerdo con estándares de control bien definidos, un resultado superior al uso de otros medios concebidos al servicio del mismo fin.

También es deseable que el instrumento sea versátil, es decir, que acepte modificaciones menores para adecuarse a las peculiaridades de los entornos de aplicación. Así, unas buenas tijeras permiten que el tornillo axial se ajuste a la carga de resistencia, que la ubicación de las agarraderas se distancie adecuadamente al nivel de fuerza que se demanda del operario, que el filo de las cuchillas de acero se pueda hacer más fino después de varias intervenciones.

El instrumento debe estar a la mano del usuario, con independencia de las particularidades del entorno de aplicación, siempre que estas se ajusten a una familia de expectativas. Unas tijeras diseñadas para cortar papel cumplen su función, sin importar si el papel es blanco, negro, azul, y también sin importar si el papel es fino u ordinario, nuevo o reciclado. El cálculo es útil bien sea para evaluar aceleraciones o establecer ritmos de crecimiento de la población.

Llamamos a esta la condición de neutralidad en el entorno de aplicación. Así, un instrumento conceptual que queramos usar para ofrecer explicaciones o anticipar acontecimientos debe ser una articulación simple de conceptos, debe superar otros medios disponibles para las mismas tareas, debe dejar abierta la posibilidad de adaptaciones orientadas a satisfacer de manera más fina tareas de la misma familia y debe ser neutral en relación con el entorno de aplicación. La vida y la naturaleza del instrumento consisten en ser utilizado.

Nos interesa defender, en este libro, una reconstrucción racional de un programa de investigación en el que se puede identificar la decisión normativa, de parte de los adherentes al programa, de mantener fijo el uso de un instrumento conceptual.

En el caso del programa de la mecánica newtoniana, los adherentes se resisten a abandonar los principios básicos (las tres leyes de la mecánica y la ley de la gravitación universal). Ellos han incorporado, en su programa, muchos instrumentos conceptuales (cálculo diferencial, cálculo integral, ecuaciones diferenciales, lagrangianos, etc.). Sin embargo, cuando han tenido que adelantar modificaciones en el cinturón protector, dadas las anomalías o instancias falseadoras, no se han aferrado a los instrumentos, sino a los principios básicos. Vamos a defender también que, en el programa de investigación que nos ocupa, los adherentes al programa han modificado compromisos ontológicos o teóricos, con el ánimo de mantener firme el uso de un instrumento conceptual. Sostenemos que, en su momento, esta práctica era razonable, dadas las circunstancias propias de la complejidad y la profundidad del tipo de preguntas que los investigadores pretendían encarar.

Asumimos, igualmente, en este libro, que el estudio de la percepción visual, entendido este como la tarea de ofrecer explicaciones o anticipaciones asociadas con la manera como aprehendemos visualmente el mundo, pudo simplificarse y sacar provecho del uso de una pirámide concebida como instrumento conceptual.

Defendemos, entonces, que este estudio, en su conjunto, puede verse como un programa de investigación, en cuyo núcleo firme reside un instrumento que se puede caracterizar de manera provisional en los siguientes dos términos: 1) percibir visualmente un objeto, que imaginamos exterior e independiente, demanda reconocer que existe (o se puede postular) una mediación que se lleva a cabo a través de trayectos rectos que convergen en el ojo (vértice de la pirámide) y divergen desde este hasta las partes de la cara visible del objeto; y 2) adscribir propiedades sensibles al objeto observado puede hacerse gracias, en buena medida, a que decodificamos las pistas geométricas presentes en la pirámide visual. Mostramos, en este trabajo, que los investigadores que acogieron dicho programa adelantaron variadas operaciones en los alrededores del cinturón protector, con el ánimo de mantener incólume el núcleo del programa, a saber, el uso de la pirámide visual como instrumento.

En otras palabras, trabajamos bajo la hipótesis según la cual el núcleo firme del programa se puede sintetizar, en una primera aproximación, en los siguientes términos: para describir la percepción visual de un objeto podemos imaginar que: 1) la cara visible de dicho objeto constituye la base de una pirámide geométrica en cuyo vértice se encuentra el aparato receptor de quien percibe; 2) la percepción es posible gracias a una mediación rectilínea entre el aparato receptor y la cara visible del objeto (bordes de la pirámide); y 3) el observador decodifica, a partir de claves geométricas, buena parte de las características con las que reviste al objeto y su relación con los demás.

Fases previstas para la reconstrucción racional

La primera formulación precisa de la pirámide visual se encuentra en los trabajos de Euclides (ca. siglo III a. C.), en la Grecia Antigua. Vamos a mostrar que la defensa del uso del instrumento puede rastrearse incluso hasta finales del siglo XIX. Si tenemos éxito en la reconstrucción racional que queremos ofrecer, hablamos entonces de una empresa que acumuló, con algunas interrupciones, cerca de veintidós siglos.

La defensa del instrumento, como mostramos en el texto, deja ver cómo el uso del mismo ha simplificado el lenguaje y el acercamiento a un inventario de preguntas de excesiva complejidad. También mostramos que, en el cinturón protector, el uso del instrumento ha demandado ajustes que responden a las anomalías detectadas en su aplicación.

Para adelantar la tarea, hemos concebido ocho fases que agrupan los estadios de evolución más representativos. Tales fases transcurren a lo largo de veintidós siglos e identifican ciertos hitos que han tenido lugar en diferentes locaciones del mundo occidental. Para hacer mención a dichas fases, hacemos un uso anacrónico de etiquetas nacionales. Somos conscientes de la inconveniencia de presuponer unidades nacionales cuando ni siquiera tenía sentido mencionarlas.13 No obstante, no hemos encontrado una mejor manera de despertar, en el lector contemporáneo, una ubicación espacial inmediata de los acontecimientos que nos interesa tejer.

La reconstrucción no pretende ser exhaustiva. Hemos dejado por fuera muchas intervenciones de gran cantidad de investigadores que de una u otra forma fueron partícipes del programa. Hemos decidido concentrarnos en intervenciones que juzgamos hitos, que marcaron claros derroteros y fueron perfilando la madurez y la evolución del programa que se empañaba en dejar abiertas las posibilidades de la aplicación de la pirámide visual como instrumento conceptual.

La figura 2 muestra, en un mapa, el despliegue de las fases. El ordinal de cada fase está acompañado, entre paréntesis, de una descripción básica del período considerado. Las fases en general aluden a un tiempo y una ubicación espacial. Algunas fases mencionan también el nombre propio de un investigador que se asume como central. En esos casos, la alusión se justifica, porque el trabajo o la obra del pensador aludido recogen una síntesis soberbia que definió de manera contundente el curso del programa de investigación.

La mención de una región y de un tiempo deja al descubierto una primera pista que debería servirle a un historiador externo para dar cuenta de las dificultades que el historiador interno no puede sortear. A manera de ejemplo: el tipo de compromisos ontológicos que asumen los investigadores y que, como pretendemos mostrar, es completamente prescindible en la defensa del instrumento, se puede explicar si se considera el espíritu de la época en el que se concibe el aporte del investigador. Cada fase delimita un capítulo del presente trabajo. Por ello, a continuación describimos, en forma muy breve y esquemática, los alcances y las pretensiones de cada capítulo.

Figura 2. Fases de la reconstrucción

Fuente: Elaboración del autor.

Capítulo 1. “La herencia griega, o de cómo se propuso la pirámide visual como instrumento conceptual”. Con anterioridad a que la pirámide visual fuera postulada por Euclides como instrumento, los griegos se debatían entre dos enfoques protagónicos para dar cuenta de los fenómenos asociados con la percepción visual: por un lado, los extramisionistas querían atribuir la sensación visual a una suerte de efluvio que tendría que emanar del ojo; por otro, los intramisionistas hacían depender el fenómeno de algún tipo de información que tendría que llegar al ojo desde el objeto contemplado.14 Cada escuela asumía compromisos ontológicos que resultaban inconmensurables con los de la otra. Así, entonces, la discusión carecía de instrumentos de control que orientaran la toma de decisiones ante teorías rivales.

Se defiende, en el capítulo, que la propuesta de la pirámide visual de Euclides (aunque formulada con lenguaje extramisionista) ofreció la primera oportunidad de contar con un enfoque que podríamos llamar “paradigmático”. Este enfoque es neutral frente a compromisos ontológicos. Así, pues, la propuesta no exige tomar decisiones en favor de uno de los dos acercamientos; permite, más bien, aplazar la discusión o llevarla a un segundo plano, mientras se da la oportunidad de concentrarse en las mejoras necesarias para que el instrumento (la pirámide) defina el lenguaje en el que habrían de formularse las preguntas pertinentes.

Acoger un instrumento neutral frente a los compromisos ontológicos en disputa se presenta en este estudio como una opción razonable para un programa que estaba por comenzar. Además de exponer las virtudes de algunos de los teoremas básicos del corpus euclidiano, el capítulo encara dos de las primeras anomalías serias del programa de investigación: la primera anomalía advierte la indeterminación entre la evaluación del tamaño y la de la distancia a la que se encuentra el objeto observado; la segunda tiene que ver con la visión binocular: nosotros no vemos con un solo ojo, como presupone el instrumento de Euclides; nosotros contemplamos el mundo con dos ojos.

Mostramos, en este capítulo, que en lugar de arrojar al olvido el instrumento, Ptolomeo (ca. 100 d. C. - ca. 170 d. C.) optó por ofrecer una mejora: los teoremas de Euclides conservan su validez si los remitimos a una pirámide virtual cuyo vértice se halla en el punto medio entre los dos ojos (la mirada de un cíclope). Así las cosas, el uso del instrumento tiene que ajustarse cuando la percepción visual demande la participación de un sistema binocular.

Presentamos también la influyente clasificación propuesta por Aristóteles (384 a. C. - 322 a. C.), que divide los sensibles en propios, comunes y por accidente. Esta clasificación, asumida casi sin reparos durante las primeras seis fases, resultó decisiva en el mayor revés del programa de investigación estudiado en la fase 7.

Capítulo 2. “Alhacén y el legado árabe, o de cómo se fija la atención en el vértice de la pirámide visual”. Otra gran dificultad cuando se quiere hacer uso de la pirámide tiene que ver con el hecho sencillo de que la acción del sensorio no puede concebirse como una actividad concentrada en un punto geométrico (el vértice de la pirámide). Una teoría completa de la percepción visual ha de tener en cuenta la estructura compleja del ojo.

Fue Galeno (ca. 130 d. C. - ca. 200 d. C.) el estudioso griego que mayores alcances y repercusión logró en relación con el estudio de la anatomía ocular. No obstante, no fue él quien llegara más lejos en el estudio de la funcionalidad geométrica de las esferas cristalinas que conforman el aparato ocular. Esta tarea fue llevada a cabo, con excelsa minuciosidad, por Alhacén (ca. 965 d. C. - ca. 1040 d. C.) en el mundo árabe.

Mostramos que aunque Alhacén propuso contundentes argumentos contra el extramisionismo y defendió el enfoque intramisionista, el uso que le daba a la pirámide visual podía hacer caso omiso de dicho compromiso. Seguimos con cuidado, en este capítulo 2, la defensa que hace Alhacén de una forma de puntillismo derivado de su compromiso ontológico. Este puntillismo condujo a proponer unas pirámides de emisión que luego tuvieron que conciliarse con la pirámide de recepción euclidiana.

El profundo conocimiento de los aportes anatómicos de Galeno, de los aparatos técnicos propios de la óptica de Euclides y de Ptolomeo, y la simpatía con el enfoque científico defendido por Aristóteles, le permitieron a Alhacén atribuir un papel protagónico a la parte posterior del cristalino en la recepción de las formas sensibles, antes de que el sensorio pudiese hacerse cargo de ellas. Buena parte de la defensa de su enfoque se basa en reconocer que una comprensión completa del fenómeno de la percepción visual demanda poner atención especial a la contribución psicológica o fenomenológica anclada en la actividad psíquica de la conciencia. Ponemos, entonces, en evidencia que, al llamar la atención hacia la funcionalidad geométrica de las túnicas y esferas cristalinas que componen el ojo, se hace absolutamente necesario hallar una ley cuantitativa para la refracción de la luz. Advertimos que esta dificultad representa uno de los mayores escollos en el desarrollo del programa de investigación.

Capítulo 3. “El despertar inglés, o de cómo se encara la mediación causal en la pirámide visual”. A comienzos del siglo XIII circuló, en Inglaterra, una traducción al latín de la obra cumbre de Alhacén. Este trabajo tuvo especial repercusión en la escuela de Oxford. Robert Grosseteste (ca. 1175-1253) y Roger Bacon (ca. 1214 - ca. 1292), franciscanos ambos, lograron una síntesis interesante entre neoplatonismo, Aristóteles y filosofía árabe, para lograr su peculiar aproximación al estudio de la metafísica de la causalidad.

El tratado de Bacon, dedicado a la multiplicación de las especies, ofreció una explicación de la manera como podría esperarse que: 1) los objetos provocaran simulacros en los medios transparentes circundantes, y 2) estos simulacros se replicaran en capas posteriores del medio, hasta conseguir que el sensorio los recibiera a la manera de especies sensibles. La descripción, que contiene elementos neoplatónicos y aristotélicos, ofrece una justificación interesante de los trayectos rectilíneos presupuestos en el uso de la pirámide visual.

Bacon también explicó, a su manera, el origen de la refracción en los caminos supuestos para la multiplicación de las especies; caminos que coinciden, además, con las trayectorias supuestas para la luz.

Mostramos, en este capítulo, que los constructos teóricos de Bacon y Grosseteste hicieron más urgente la tarea de aprehender una ley cuantitativa para la refracción de la luz y de las especies sensibles. También que, aunque la pirámide visual se podía usar como un instrumento que ayuda a plantear y resolver enigmas, la tensión entre extramisionismo e intramisionismo seguía latente. En ese orden de ideas, resultaba razonable recomendar el uso del instrumento, aplazando las querellas mencionadas.

Por avatares de las circunstancias humanas, la obra de Bacon no tuvo la circulación que merecía en Europa. Las ideas del filósofo franciscano circularon por Europa mimetizadas en las obras de John Pecham (ca. 1230 - ca. 1292), franciscano y arzobispo de Canterbury, y del polaco Erazmus Ciolek Witelo (ca. 1230-1314).

Capítulo 4. “El Renacimiento italiano, o de cómo los pintores interpusieron un velo a la pirámide visual”. Dos acontecimientos marcaron definitivamente el mundo académico e intelectual de la Florencia renacentista: el descubrimiento de la Geografía de Ptolomeo y el experimento de Filippo Brunelleschi (1377-1446). Ambos ofrecían, y demandaban a la vez, protocolos precisos para la representación bidimensional de la ubicación tridimensional de objetos a la mano. La Geografía de Ptolomeo hizo posible las más bellas representaciones artísticas de mapas del mundo conocido en Europa. El experimento de Brunelleschi detonó la invención de la perspectiva lineal.

La perspectiva puede concebirse como un instrumento conceptual al servicio de una práctica pictórica, un instrumento útil para engañar al espectador de un cuadro, quien cree ver un universo tridimensional en los trazos que se logran en un panel bidimensional.

Dos teóricos del Renacimiento, de los que nos ocupamos en este capítulo 4, se encargaron de ofrecer sendas síntesis de los principios de la perspectiva. Nos referimos a Leon B. Alberti (1404-1472) y al exquisito pintor Piero della Francesca (ca. 1415-1492).

Alberti propuso que para aplicar las técnicas perspectivas convenía concebir el lienzo del pintor como un plano que habría de intersecar la pirámide visual entre el objeto a ser representado y el observador calculado como espectador de la obra. Así las cosas, el pintor debe ocuparse de los contornos que el velo pictórico delimita al cruzar la pirámide visual que contiene al objeto a ser representado en la base y al espectador previsto para la obra en el vértice. Ese velo debe atravesar la pirámide a la distancia que se ha calculado entre espectador y obra.

Los teóricos del Renacimiento tuvieron alguna familiaridad con las obras de Pecham y de Witelo. Los pintores que acogieron las técnicas de la perspectiva lineal lograron soberbias obras pictóricas en las que, por primera vez, sometieron la construcción del espacio a una estricta regularidad geométrica prevista de antemano.

Ahora bien, la invención de la perspectiva no tenía como propósito impactar o revolucionar la forma como estábamos concibiendo constructos teóricos para la percepción visual. No obstante, mostramos que dicha invención hizo posible que nos atreviéramos a pensar que si una composición de trazos en el papel nos hace ver objetos distribuidos tridimensionalmente, siempre que su composición se ajuste a estrictas reglas de proyección, bien podemos pensar que cuando observamos paisajes naturales y creemos contemplar objetos distribuidos en tercera dimensión es porque aplicamos ejercicios de decodificación que se ajustan a la misma normatividad con la que producimos simulacros pictóricos. En ese orden de ideas, las reglas de proyección perspectiva constituyen una especie de categorías previas con las cuales construimos el espacio propio de la percepción sensible.

Capítulo 5. “Kepler y el horizonte alemán, o de cómo se estableció el protagonismo de la retina”. La reconstrucción racional nos ha llevado a ver, en la obra del astrónomo alemán Johannes Kepler, la síntesis más profunda del programa de investigación. En ese orden de ideas, la obra de Newton es a la mecánica celeste del programa copernicano, lo que el trabajo de Kepler es a nuestro programa de investigación.

Cuando Kepler llegó a la corte de Praga para trabajar junto con Tycho Brahe (1546-1601), notó que el astrónomo danés hacía uso de cámaras obscuras para tomar datos astronómicos —las mismas cámaras que con relativo éxito ya venían usando algunos pintores—. Kepler advirtió que los datos, así tomados, relativos al tamaño de la Luna, diferían notablemente de los registros conservados desde la Antigüedad clásica.

Antes que atribuir la discrepancia a serios errores cometidos por los astrónomos griegos, el filósofo quiso pensar que la dificultad se encontraba en el hecho de que aún no se dominaba cabalmente la matemática propia de la formación de imágenes en este tipo de instrumento. La formación de imágenes detrás de pequeños agujeros era un misterio ya advertido desde los tiempos de Aristóteles y había consumido buena parte del trabajo de Alhacén, Roger Bacon, Pecham y Witelo. El matemático se valió de una idea sugerida en los grabados del pintor alemán Alberto Durero (1471-1528) y resolvió, en forma impecable, el difícil problema; también advirtió que mientras no se hallara una ley precisa para la refracción que ayudara a prever qué tanto se desvía la luz del cielo al ingresar a la atmósfera terrestre y a identificar con claridad cómo se forman imágenes en el ojo, jamás podríamos corregir las desviaciones ópticas en los datos tomados del cielo. Sin ese recurso, no podríamos ofrecer una defensa completa del programa copernicano que tanto apreciaba Kepler.

El filósofo alemán se impuso, pues, la tarea de hallar una ley cuantitativa precisa que permitiera anticipar cómo se refracta la luz al pasar a medios que difieren en densidad óptica. Mostramos en este capítulo, cuidadosamente, que la heurística de Kepler se ajustaba, de manera perfecta, a una metodología pitagórica. Buscamos desentrañar los intrincados caminos que le condujeron a proponer una ley compleja.

Esta ley no coincide con el resultado que años más tarde se incorporó a la tradición como la “ley de Snell-Descartes”. A pesar de la diferencia con la ley que llegó a ser paradigmática, Kepler pudo valerse de su conjetura para lograr dos resultados absolutamente esenciales en nuestro programa de investigación. Al primer resultado lo hemos llamado “teorema fundamental de la óptica”. Sostiene este teorema que si un haz de luz proveniente de una fuente homocéntrica ingresa al ojo por caminos no muy alejados del eje visual, este haz seguirá, en el interior del ojo, trayectos que le permiten concentrarse nuevamente en un punto.

El segundo resultado afirma que cuando, en el interior del ojo, el punto de convergencia de un haz homocéntrico se ubica precisamente en la retina, se logra con ello una visión clara del objeto emisor. En otras circunstancias, la contemplación de la fuente puntual le aparece al observador acompañada de sombras o resplandores que la bordean.

Este resultado 1) impuso, en el programa de investigación, el protagonismo de la retina, al identificarla como el locus de la recepción de las formas sensibles; 2) resolvió la dificultad de Alhacén para conciliar las múltiples pirámides de emisión con la única pirámide de recepción euclidiana, y 3) impuso el modelo de la cámara obscura con un lente en la abertura como símil prometedor para ocuparse del funcionamiento del ojo.

Kepler, al concebir la recepción visual en forma análoga a una cámara obscura, demandaba diferenciar entre imagen y pintura. El astrónomo alemán también impuso la urgencia de una explicación adecuada de cómo es que logramos ver objetos en la distribución espacial adecuada, si las pinturas recogidas en el fondo de la retina han de aparecer invertidas.

El filósofo alemán declaró que la contribución de la óptica al esclarecimiento de la percepción visual solo podía llegar hasta la formación de pinturas en la retina. Ya tendría que ser tarea de una filosofía completa de la percepción explicar cómo estas pinturas pueden convertirse después en imágenes para el sensorio.

Capítulo 6. “La síntesis francesa, o de cómo se introdujo un sujeto cuyos estados perceptuales covarían con las escenas pictóricas que recibe”. René Descartes (1596-1650), como lo deja ver en una de sus comunicaciones privadas, se sentía, a propósito de la óptica, heredero del espíritu de Kepler. La incomodidad que sentía Descartes con el modelo de explicación científica inspirado en Aristóteles condujo al filósofo a proponer un estilo anclado en el mecanicismo. El giro consistió en abandonar las vacías formas substanciales aristotélicas, que habían llevado a los escolásticos a caer en seudoexplicaciones que incurrían fácilmente en circularidad, para substituirlas por el escueto reconocimiento de extensión y movimiento como los únicos atributos a partir de los cuales podríamos dar cuenta de todas las afectaciones en el mundo físico. En la fábula del mundo, que el autor concibió para Le traité de la lumiere, se sostiene que la luz es la manifestación sensible de la presión centrífuga que todo el universo, girando en múltiples vórtices, ejerce sobre las paredes de la retina. En esta descripción, la retina aparece como una membrana sensible a la presión centrífuga que el universo, en su conjunto, ejerce en el lugar donde ella se encuentre.

La presión centrífuga en las paredes de la retina se absorbe como presión mecánica que es transmitida por los nervios hasta el centro del cerebro, en donde reposa, de acuerdo con la anatomía conocida por Descartes, la glándula pineal. Cada arreglo de presiones en la retina provoca un único arreglo de inclinaciones de la glándula pineal. El alma, al sentir, tiene maneras de aprehender el modo de inclinación de dicha glándula y cuenta con un repertorio de sensaciones que covaría con las posibilidades de inclinación mecánicamente prevista para dicha glándula.

Ahora bien, dado que la filosofía cartesiana demanda una distinción real entre substancia extensa y substancia pensante, hemos de admitir la existencia de una ruptura al parecer insalvable (un hiato de continuidad) entre descripción mecánica de la afectación de la retina y de la glándula pineal, por un lado, y la pasión sensorial propia de la percepción mental, por el otro. Si bien 1) el mecanicismo cartesiano, dados los instrumentos de control para la época, ofrece una explicación plausible de los trayectos rectilíneos presupuestos en la mediación de la pirámide visual, y 2) Descartes propuso y justificó adecuadamente una ley de la refracción que logró incorporarse como paradigmática en la tradición científica, su enfoque provoca un hiato insalvable entre descripción mecánica y descripción atada a la vida de la conciencia.

Nicolás Malebranche (1638-1715), cartesiano por vocación, revisó el tipo de causalidad que todos los sistemas de filosofía habían presupuesto hasta el momento, incluyendo el modelo cartesiano. Esta revisión lo condujo a sostener que los acontecimientos entre los cuales intentamos tender lazos causales no están unidos por ningún vínculo necesario. En ese orden de ideas, la causalidad es una ilusión que se teje entre eventos que se repiten ocasionalmente. Así las cosas, no tenemos por qué esperar ningún vínculo necesario entre afectaciones mecánicas en la retina y contemplaciones perceptuales de la conciencia. La vinculación ocasional solo puede explicarse en virtud de la presencia activa de Dios.

Malebranche salva el hiato provocado por Descartes postulando que nosotros percibimos los objetos en Dios. Mostramos, en el capítulo 6, que estas inmersiones en compromisos de naturaleza metafísica no impiden el uso instrumental de la pirámide visual, aunque arrojan serias dudas a la propuesta de ver tal pirámide como un instrumento disponible para la conciencia.

Capítulo 7. “Berkeley y la deconstrucción irlandesa, o de cómo se desvanecen castillos construidos en el aire”. George Berkeley (1685-1753), quien no tuvo reparos en presentar su modelo como la contribución de Irlanda a la filosofía, logró atar en forma consistente la influencia que recibió de John Locke (1632-1704), Descartes y Malebranche. Este ejercicio le condujo a revisar muy cuidadosamente la manera como creemos percibir la distancia, valiéndonos de pistas visuales.

Su desconfianza profunda en el modo como Locke caracterizaba las ideas abstractas llevó a Berkeley a defender un resultado sorprendente para los alcances del programa de investigación que nos ocupa. La conciencia no puede, y no tendría cómo, valerse de ángulos o de líneas rectas para la anticipación de objetos que pudiesen encontrarse a distancia de nosotros. Así las cosas, la pirámide visual contribuye a formar, en nosotros, una ilusión sin fundamento.

Si atendemos los reclamos de Berkeley, nos vemos obligados a evaluar el uso de la pirámide visual como si fuera un obstáculo epistemológico, un instrumento que, a pesar de su utilidad, induce en nosotros ficciones problemáticas. La propuesta de Berkeley ofrece un poderoso programa de investigación rival que, en virtud de la fuerza de sus argumentos, o bien obliga a abandonar el poderoso instrumento, o bien obliga a replantear su uso.

Los argumentos de Berkeley le ayudaron también a tejer su inmaterialismo y a defender, con una fuerza casi irrebatible, la tesis de la heterogeneidad. Según esta tesis, no existen los sensibles comunes postulados por Aristóteles; no tiene sentido que insistamos en presentar la información visual y la información táctil como si ellas refirieran a propiedades de objetos abstractos que, con su existencia independiente del observador, detonan causalmente dos presentaciones diversas de lo mismo. En otras palabras, la distancia que creemos percibir con pistas visuales no tiene vínculos de necesidad alguna con la distancia que atribuimos a evaluaciones táctiles. Los vínculos que podemos trazar entre distancias tangibles y distancias visuales han de ser contingentes. Hemos aprendido a asociar claves visuales con presentaciones táctiles y en virtud de la repetición exitosa de estas asociaciones hemos llegado a creer que contemplamos el mismo objeto por dos canales diferentes.

El poderoso trabajo de Berkeley sugiere, con una plausibilidad asombrosa, que la información visual pueda tenerse simplemente como recurso simbólico para anticipar afectaciones táctiles, si solo nos apoyamos en la repetición exitosa de instancias que guardan semejanza con las iniciales.

Si aceptamos los reclamos de Berkeley y reconocemos que la conciencia no puede valerse de pirámide alguna para fundamentar o justificar su forma de aprehensión visual, ¿era razonable renunciar a la posibilidad de seguir sacando provecho teórico y empírico del uso del instrumento que ayudó a formular preguntas y orientó el camino para hallar su solución?

El filósofo irlandés se animó a sugerir el problema planteado por el médico irlandés William Molyneux (1656-1698) como la plataforma para concebir un experimento crucial que habría de ofrecer las condiciones para decidir entre su sistema (atado a la tesis de la heterogeneidad) y los sistemas rivales. Molyneux preguntaba si un ciego de nacimiento, que ha llegado a tener habilidad para desenvolverse en un universo de objetos tangibles, podría llegar a reconocer propiedades asignadas a dichos objetos en el caso de que recuperara repentinamente la visión y pudiera contemplar los objetos sin tener ahora necesidad de recorrerlos con el tacto. Así, evaluamos en el capítulo si este dilema nos permite o no concebir un experimento crucial que imponga la tesis de la heterogeneidad defendida por Berkeley.

La defensa del inmaterialismo de Berkeley, queremos mostrar, no condena como absurdo el cultivo de la física. Esta última no tiene por qué comprometerse con la materia abstracta que preconizan los contradictores del filósofo. Esta ciencia puede verse como el arte de anticipar activaciones sensoriales a partir de instrumentales teóricos, junto con afectaciones sensoriales como condiciones iniciales. Así, entonces, la pirámide visual puede seguir siendo un instrumento exitoso para ofrecer descripciones físicas asociadas con la naturaleza de la luz, la interacción de la luz con objetos macizos, con lentes y tejidos vivos.

Por lo tanto, podemos seguir pensando (trazando o imaginando) trayectos rectos que convergen en receptores sensoriales, todo ello para evaluar posibles alternativas de desarrollo futuro. Lo que ya no es razonable hacer, si acogemos el programa de Berkeley, es postular la pirámide como la herramienta básica que le permite a la conciencia aprehender información del ambiente.

Esta curiosa situación nos ha obligado a acoger la distinción entre enfoques de tercera persona, para los que es razonable esperar todavía posibilidades interesantes para la pirámide visual, y enfoques de primera persona, para los que la pirámide puede llegar a tenerse por un obstáculo epistemológico.

Capítulo 8. “Helmholtz y el auge de la óptica alemana, o de cómo se concilian enfoques en tercera y primera persona”. El poderoso arsenal de argumentos de Berkeley habría hecho razonable esperar un estancamiento radical del programa de investigación. No obstante, no hubo siglo más rico que el siglo xix en la producción de anticipaciones teóricas novedosas, acompañada de una profusión de evidencias empíricas prima facie favorables para el programa. El foco de toda esta creatividad se concentró básicamente en Alemania.

En Inglaterra, por su parte, se vivió con euforia el desarrollo de las técnicas microscópicas y la demanda de constructos teóricos que hicieran más fino el uso de tal instrumento. Este dispositivo nos entregó un universo nuevo, lleno de sorpresas y enigmas.

No obstante, las técnicas para el mayor perfeccionamiento cristalizaron en el entorno alemán. La explosión de creatividad alemana se explica por la inauguración de dos programas de investigación fundamentales: por un lado, el nacimiento de la fisiología, anclada en los principios de la mecánica y de la química; por otro, el origen y posterior fundamentación de la psicología experimental.

El Handbuch der Physiologie des Menschen (1840), de Johannes Müller (1801-1858), inauguró un nuevo plan de investigaciones. Hermann von Helmholtz (1821-1894), discípulo de Müller, acogió la nueva fisiología y produjo el tratado de óptica más completo que habría de contener, entre otras cosas, la fundamentación y las aplicaciones más sofisticadas de la pirámide visual. Nos referimos al Handbuch der Physiologischen Optik, publicado en tres volúmenes entre 1856 y 1866. Así mismo, Whilhelm Wundt (1832-1920), también discípulo de Müller, creo en Leipzig (1879) el primer laboratorio de psicología experimental. Lo hizo con el ánimo de estudiar empíricamente los contenidos de la conciencia en el marco de la aprehensión sensorial.